Make U-Nets Great Again!北大&华为提出扩散架构U-DiT,六分之一算力即可超越DiT

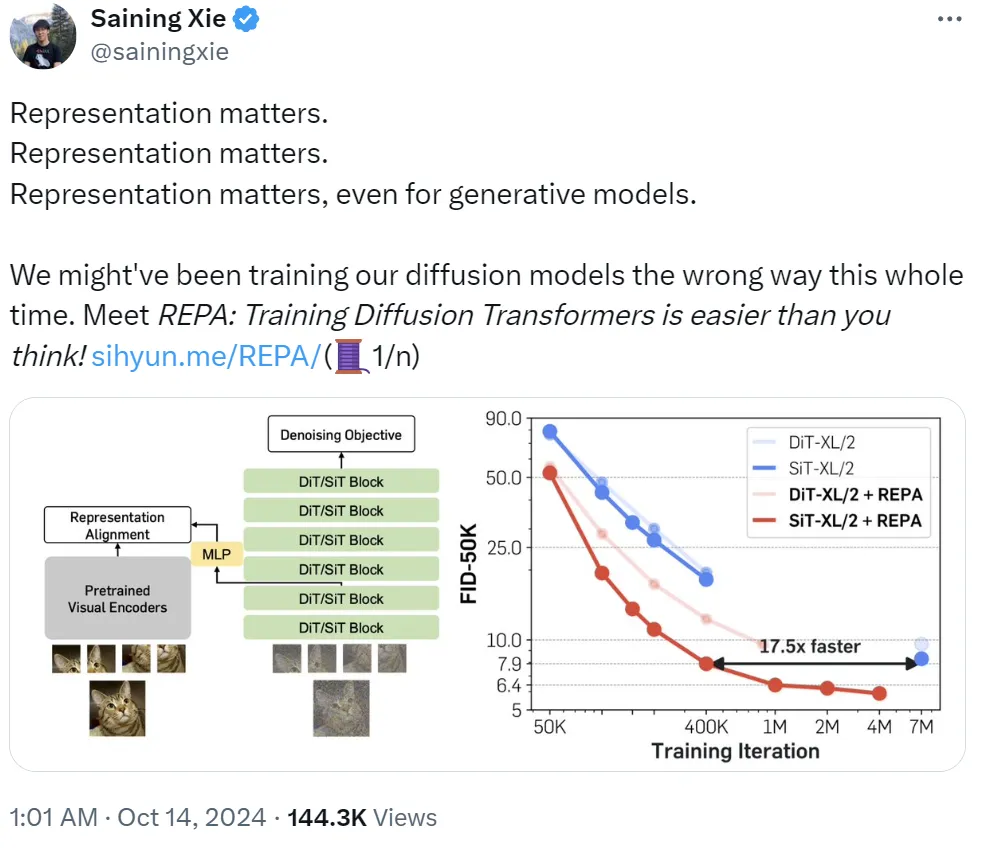

Make U-Nets Great Again!北大&华为提出扩散架构U-DiT,六分之一算力即可超越DiTSora 的发布让广大研究者及开发者深刻认识到基于 Transformer 架构扩散模型的巨大潜力。作为这一类的代表性工作,DiT 模型抛弃了传统的 U-Net 扩散架构,转而使用直筒型去噪模型。鉴于直筒型 DiT 在隐空间生成任务上效果出众,后续的一些工作如 PixArt、SD3 等等也都不约而同地使用了直筒型架构。